Je schadefoto is niet meer te vertrouwen: AI-afbeeldingen als nieuw frauderisico

Hoe AI-afbeeldingen schadeclaims, retouren en interne processen onder druk zetten. En wat jij als organisatie nu al kunt doen.

De foto liegt

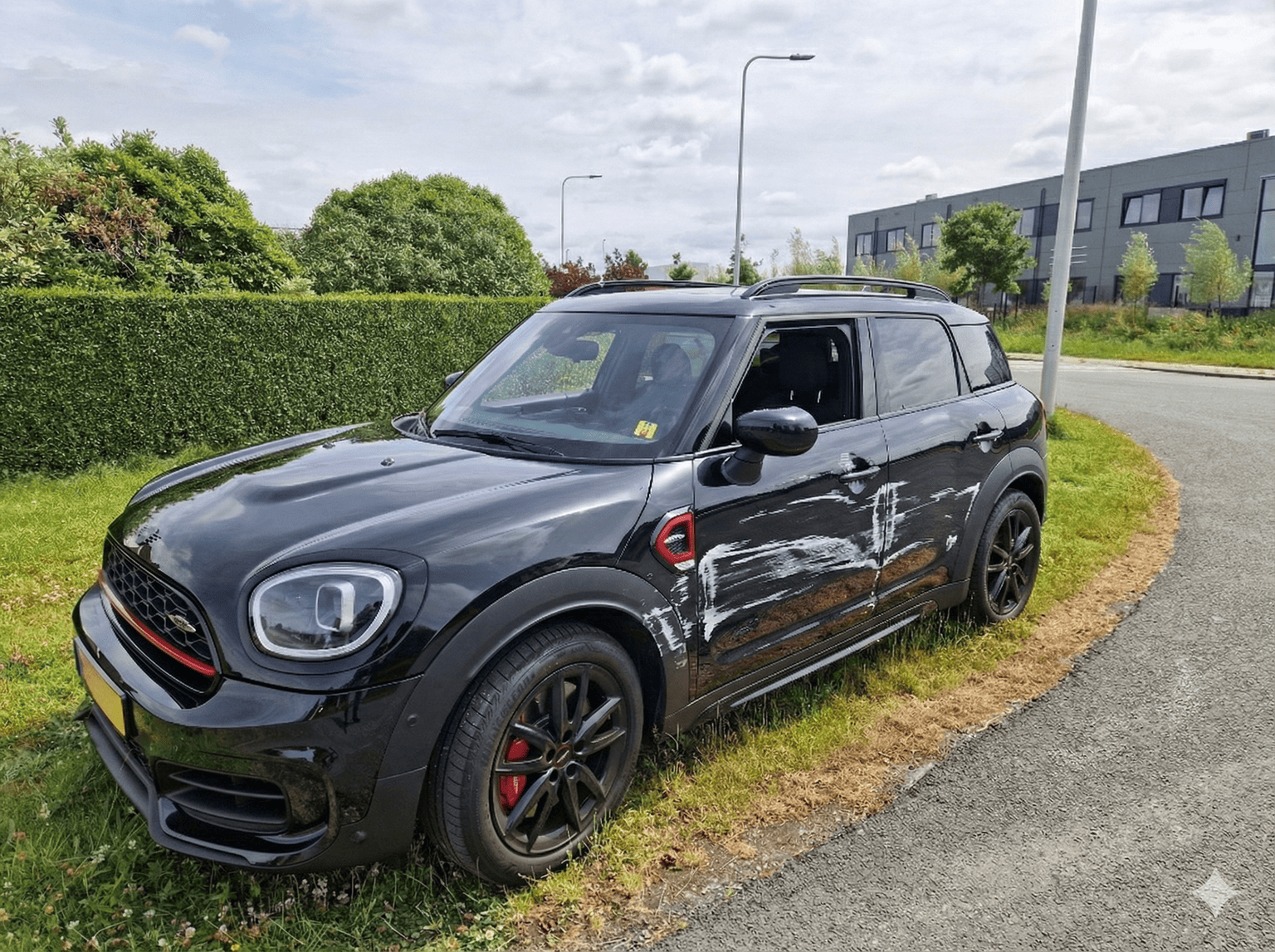

Kijk eens goed naar de twee foto's hieronder.

De bovenste foto is het origineel. De onderste heb ik binnen enkele seconden bewerkt met de bekende "Nano Banana" AI-tool van Google.

Het resultaat? Een foto die prima door zou kunnen gaan als onderbouwing van een schadeclaim. De krassen zien er realistisch uit, de schaduwen kloppen, en zelfs de reflecties in de lak zijn meegenomen.

Dit is precies het risico waar verzekeraars, en eigenlijk alle organisaties die beslissingen nemen op basis van foto's, mee te maken krijgen. Je ziet aan de voorkant een "echte" foto, maar je weet niet meer of de schade ook echt is gebeurd.

En dat is een probleem. Een groot probleem.

Shallowfakes vs Deepfakes

Je hebt vast weleens gehoord van deepfakes: die nepvideo's waarin bekende mensen dingen zeggen die ze nooit hebben gezegd. Maar er is een nieuwere, subtielere variant waar je waarschijnlijk minder over hoort: shallowfakes.

Een shallowfake is een foto die deels echt is, maar waar met AI elementen aan zijn toegevoegd of veranderd. Denk aan een echte auto waar nepschade op is geplakt. Of een echt product waar een "beschadiging" aan is toegevoegd die er nooit was.

Het verschil met de klassieke Photoshop-knutsel? De drempel is dramatisch verlaagd. Waar je vroeger uren moest werken om een geloofwaardige bewerking te maken, doe je dat nu in minuten. De tools zijn zo goed geworden dat:

- Reflecties, schaduwen en texturen automatisch meegaan

- De bewerking naadloos opgaat in de originele foto

- Zelfs de metadata van de foto kan worden aangepast

Voorbeelden van huidige situaties

Het is momenteel al op verschillende plekken in het nieuws

Gemanipuleerde autoschade in het Verenigd Koninkrijk

Britse verzekeraars zien een stijging van fraudezaken waarbij foto's van voertuigen worden bewerkt om extra of zwaardere schade te tonen. Fraudeurs "pimpen" foto's digitaal met extra krassen en deuken die er nooit waren. Het resultaat: hogere claims, hogere premies voor iedereen, en meer druk op de hele markt.

170 keer dezelfde foto, meer dan een miljoen dollar schade

Een veelvoorkomende truc die fraudeurs al jaren gebruiken: dezelfde foto van eerdere schade opnieuw indienen als "nieuwe" claim. Zeker als iemand overstapt naar een andere verzekeraar, valt dit lastig te detecteren. Er is immers geen historie van eerdere foto's.

Maar het zijn niet alleen klanten die dit doen. Verisk, een Amerikaans bedrijf gespecialiseerd in fraudedetectie, hielp een verzekeraar bij het onderzoeken van een taxateur. Het resultaat? In twee jaar tijd had deze taxateur 170 dubbele foto's ingediend bij verschillende claims. Totale schade voor de verzekeraar: meer dan een miljoen dollar aan uitgekeerde claims.

Zonder geautomatiseerde detectie was dit waarschijnlijk nooit aan het licht gekomen. Het menselijk oog kan simpelweg niet onthouden of een specifieke foto al eerder is gebruikt, zeker niet bij duizenden claims per jaar.

Zurich spoort dagelijks £260.000 aan fraude op

Verzekeraar Zurich zet AI in die elke binnenkomende claim in realtime analyseert. Hun systeem kan zelfs onderscheid maken tussen verschillende soorten schade, zoals krassen versus deuken, en checkt of die schade logisch past bij het verhaal van de klant. In 2024 detecteerde Zurich UK hiermee dagelijks zo'n £260.000 aan frauduleuze claims, nog voordat er geld werd uitgekeerd.

Dit gaat verder dan verzekeringen

Als je denkt "dit is een probleem voor verzekeraars, niet voor mij", denk nog eens na. Elke organisatie die beslissingen neemt op basis van foto's krijgt hiermee te maken.

E-commerce en retouren

Klanten sturen AI-gegenereerde foto's van "beschadigde" producten om hun geld terug te krijgen zonder het product daadwerkelijk te retourneren. De foto toont een kapot scherm of een beschadigde verpakking die er nooit was.

Bezorgdiensten

Foto's van "kapotte" pakketjes die nooit zo zijn aangekomen. De bezorger krijgt de schuld, de klant krijgt een vergoeding, en niemand kan bewijzen wat er echt is gebeurd.

HR en facility management

Gemanipuleerde beelden van werkplekincidenten, veiligheidsschendingen of materiële schade. Lastig te ontkrachten, makkelijk te fabriceren.

Financiële sector

Deepfake documenten en identiteitsbewijzen worden al gebruikt om accounts te openen en kredieten te frauderen. Paspoorten, loonstroken, bankafschriften: alles kan worden nagemaakt.

De rode draad? Waar foto's als bewijs gelden, wordt AI een risico.

Hoe werkt dit technisch?

Je hoeft geen IT-specialist te zijn om te begrijpen hoe dit werkt. De kern is simpel.

Inpainting is de meest gebruikte techniek. Je selecteert een deel van een foto, bijvoorbeeld een stuk bumper, en je typt wat je wilt zien: "diepe kras" of "deuk". De AI vult de rest in, inclusief de juiste schaduwen, reflecties en texturen. Het resultaat ziet eruit alsof het er altijd al was.

Metadata-spoofing verwijdert of overschrijft de digitale "vingerafdruk" van een foto. Wanneer een foto is gemaakt, met welk apparaat, op welke locatie: al die informatie kan worden aangepast of verwijderd.

En het meest verraderlijke: combineren met echte data. Echte kentekens, echte straatbeelden, echte klantnamen, gecombineerd met nepschade. Dit maakt het extra geloofwaardig voor menselijke beoordelaars, want "de rest klopt toch allemaal?"

Hoe bedrijven zich wapenen

Gelukkig lopen veel bedrijven al voor in het ontwikkelen van tegenmaatregelen. En daar kun je als andere organisatie van leren.

AI tegen AI

Verzekeraars zetten nu AI-powered image fraud detection in. Deze systemen kijken naar dingen die het menselijk oog mist:

- Manipulaties in pixels, randen en lichtval

- Hergebruik van dezelfde foto in meerdere dossiers

- Inconsistenties tussen de zichtbare schade en het opgegeven scenario

Een mooi voorbeeld van verzekeraar Zurich: hun AI signaleerde dat krassen op een motorkap niet pasten bij het verhaal van de klant (een carwash-incident). De hoek van de krassen, de diepte, de locatie, het klopte gewoon niet. Claim afgewezen.

Content provenance

Grote partijen werken aan standaarden om de herkomst van digitale content traceerbaar te maken. Denk aan een soort "digitaal paspoort" voor foto's: waar komt dit beeld vandaan, is het bewerkt, en zo ja, hoe?

Google's Nano Banana bevat bijvoorbeeld al een watermerk, die een andere AI kan zien.

Wat kun jij nu al doen?

Hier een praktische checklist die jij binnen jouw organisatie zo kunt toepassen.

1. Processen en beleid aanscherpen

Maak duidelijk wanneer een foto écht bewijs is

Niet elke foto hoeft dezelfde status te hebben. Maak onderscheid tussen "nice to have" en "formeel bewijs voor een beslissing". Voor die laatste categorie horen extra checks. Geen blind vertrouwen.

Bouw een vier-ogen-principe in

Gaat het om grote bedragen of gevoelige claims? Laat dan standaard een tweede paar ogen meekijken. Twee mensen zien eerder inconsistenties dan één.

Leg vast dat je mag controleren

Neem in je voorwaarden op dat je beeldmateriaal mag laten onderzoeken op manipulatie. Dat werkt zowel preventief (het schrikt fraudeurs af) als juridisch dekkend.

2. Bewijs-eisen slimmer maken

Vraag om meerdere foto's

Eén foto is zo gemanipuleerd. Meerdere foto's vanuit verschillende hoeken en afstanden maken het veel lastiger om geloofwaardig te rommelen.

Gebruik tijdstempel en locatie

Laat waar mogelijk foto's met geotag en tijdstempel aanleveren. Klopt de locatie met het verhaal? Klopt het tijdstip met het incident? Simpele checks, maar sterke checks.

Combineer verschillende vormen van bewijs

Vertrouw niet alleen op beeld. Foto + factuur + inspectierapport is veel sterker dan één losse foto. Hoe meer puzzelstukjes met elkaar moeten kloppen, hoe lastiger fraude wordt.

Laat de klant in eigen woorden uitleggen wat er is gebeurd

Vraag altijd om een korte beschrijving. Matcht het verhaal met wat je op de foto ziet? Afwijkingen zijn vaak de eerste rode vlag.

3. Technische maatregelen inzetten

Start met AI-fraudedetectie op beelden

Er zijn tools die foto's automatisch scannen op manipulatie en inconsistenties. Begin klein: test dit eerst op de processen met het hoogste risico.

Log alle uploads centraal

Sla alle ingestuurde foto's centraal op. Zo kun je hergebruik van dezelfde beelden in meerdere dossiers herkennen.

Overweeg forensics-tools voor kritieke processen

Voor high-risk processen (grote bedragen, identiteitscontrole, belangrijke contracten) kun je gespecialiseerde tools inzetten die veel verder kijken dan het menselijk oog.

4. Train je team

Leer medewerkers de rode vlaggen herkennen

Denk aan:

- Schade die niet logisch is gezien het verhaal

- Vreemde patronen of herhalende structuren in oppervlakken

- Een te "perfecte" blur of rare overgangen

- Schaduwen en reflecties die niet kloppen met de omgeving

Gebruik interne voorbeelden

Laat echte én gemanipuleerde foto's zien uit oefencases. Als mensen eenmaal hebben gezien hoe makkelijk het is om schade "bij te tekenen", gaan ze automatisch kritischer kijken.

5. Juridische en AVG-check

Zorg dat je AVG-proof bent

Check vooraf:

- Mag je AI gebruiken op door klanten aangeleverde beelden?

- Hoe informeer je klanten over extra controles op fraude?

- Hoe lang bewaar je beeldmateriaal en voor welk doel?

Als dit helder is vastgelegd, kun je veel steviger optreden als je een claim of verzoek niet vertrouwt. Zonder gedoe achteraf.

Waar dit heen gaat

De verwachting is dat AI-fraude met beelden sneller groeit dan de meeste organisaties hun processen kunnen aanpassen. Toezichthouders en analisten voorspellen dat AI-gedreven financiële fraude de komende jaren een veelvoud wordt van de huidige cijfers.

Maar, en dit is belangrijk, AI is ook precies de technologie die je nodig hebt om dit te bestrijden. Het is een wapenwedloop, zeker. Maar het is een wapenwedloop waarin je niet machteloos bent.

De sleutel zit hem in beginnen. Nu. Niet wachten tot je zelf slachtoffer wordt.

Tot slot: twee vragen voor jou

- Op welke plekken in jouw organisatie vertrouw je nu nog blind op foto's?

- Welke claim of retour zou je morgen al door een extra check willen laten halen?

De vraag is niet óf je organisatie met nepbeelden te maken krijgt, maar wanneer. Hoe minder je processen leunen op blind vertrouwen in een foto, hoe beter je klaar bent voor wat komen gaat.