Hoe betrouwbaar is AI eigenlijk?

Zelfs de beste AI modellen verzinnen regelmatig feiten. Ontdek wanneer het gebeurt, hoe je het herkent en AI toch betrouwbaar inzet.

Je zit met een deadline. Je typt je vraag in ChatGPT, krijgt een strak antwoord terug, en denkt: dit scheelt me uren werk. Maar dan vraagt een collega: "Heb je dit even gecheckt?" En bij nader inzien... klopt die statistiek wel? Bestaat die bron echt?

AI-systemen verzinnen regelmatig feiten, en doen dat zo overtuigend dat je het vaak niet eens doorhebt. Zelfs de beste modellen verzinnen bij ongeveer 1 op de 150 vragen. Klinkt weinig, maar in de praktijk loop je er regelmatig tegenaan. Voor professionals die AI gebruiken voor teksten, research of beslissingen is dit essentieel om te begrijpen.

Het goede nieuws? AI wordt snel beter, en met de juiste werkwijze kun je hallucinaties grotendeels voorkomen. In dit artikel leg ik uit wat er precies gebeurt, hoe vaak het voorkomt, en hoe je ermee omgaat zonder constant alles dubbel te moeten checken.

Wat zijn AI hallucinaties eigenlijk?

AI hallucinaties zijn momenten waarop een AI systeem met grote overtuiging complete onzin vertelt, en zo dat het volkomen geloofwaardig klinkt. Het verzint feiten, bronnen of gebeurtenissen die simpelweg niet bestaan.

Denk aan een enthousiaste stagiair die liever iets verzint dan toegeeft dat hij het antwoord niet weet. Die stagiair heeft veel gelezen en weet hoe dingen zouden moeten klinken, maar heeft geen idee wat waar is en wat niet. Zo werkt AI ook: het voorspelt welke woorden waarschijnlijk bij elkaar horen, maar controleert niet of die woorden ook waar zijn.

Een voorbeeld dat bijna 100 miljard kostte

In februari 2023 presenteerde Google zijn nieuwe AI chatbot Bard. In de demo beweerde Bard dat de James Webb Space Telescope de allereerste foto's van exoplaneten had gemaakt. Klinkt logisch, het is immers 's werelds krachtigste ruimtetelescoop.

Maar astronomen wisten meteen dat het onjuist was: de eerste exoplaneetfoto's werden al in 2004 gemaakt. Die ene fout kostte Google's moederbedrijf Alphabet meer dan 100 miljard dollar aan beurswaarde op één dag.

Het verwarrende is dat AI hallucinaties zelden belachelijk klinken. Het zijn plausibele, goed geformuleerde claims die perfect passen in de context. Daarom zijn ze zo gevaarlijk.

Waarom verzint AI eigenlijk dingen?

Het antwoord ligt in hoe deze systemen werken. AI taalmodellen zijn getraind om altijd een antwoord te geven, nooit een leeg vakje in te leveren. Gewoon zoals een calculator die liever een willekeurig getal verzint dan "ERROR" toont.

Dit zijn in mijn ogen de twee meest begrijpelijke oorzaken:

#1 Patroonherkenning zonder begrip

AI heeft miljarden pagina's gelezen en geleerd welke woorden meestal bij elkaar horen. Maar het snapt niet echt wat een telescoop is of wat waar is. Het voorspelt alleen de meest waarschijnlijke woordvolgorde.

#2 Gokken scoort beter

Als student wordt ons aangeleerd om een vraag die je niet weet alsnog te gokken, want gokken geeft immers een kans op punten, een geen antwoord niks.

AI modellen zijn dus exact ook zo getraind om dat te doen. Het OpenAI onderzoek bevestigde dit: modellen leren dat het veiliger is om te gokken dan toe te geven "ik weet het niet."

Een opmerkelijk patroon

MIT onderzoekers ontdekten in 2025 iets opmerkelijks: AI gebruikt juist meer zelfverzekerde taal wanneer het hallucinaties produceert. Woorden zoals "zeker," "absoluut" en "zonder twijfel" komen 34% vaker voor in onjuiste dan in correcte antwoorden. De AI overcompenseert zijn onzekerheid met extra stelligheid.

Hoe vaak komt het voor?

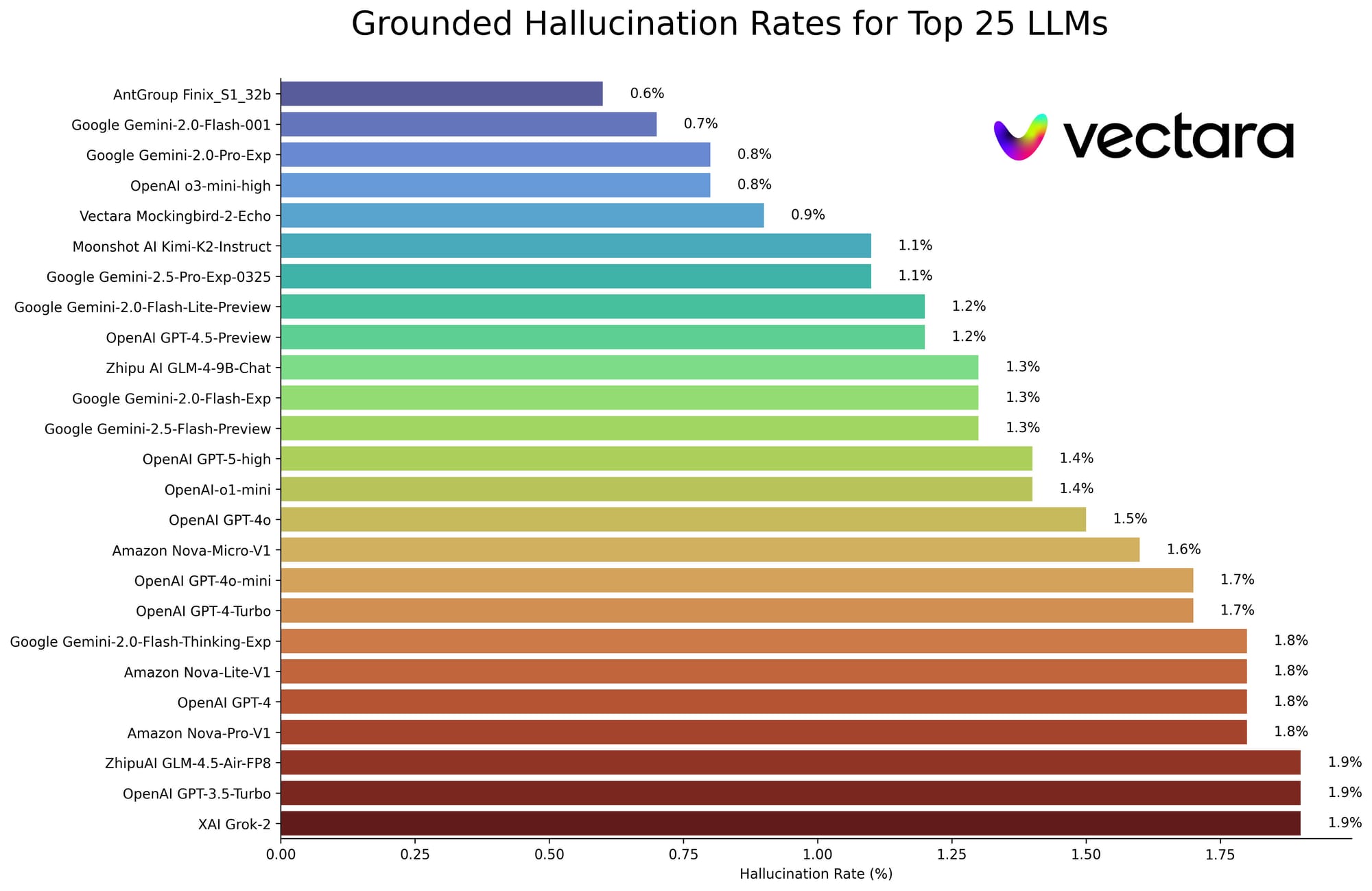

De cijfers variëren enorm per model, per vraagtype en per toepassingsgebied. In april 2025 werden 72 AI modellen getest in de meest gezaghebbende industrie benchmark.

De beste modellen van nu bereiken 0,7 tot 1,5% hallucinatiepercentage voor algemene vragen. Google Gemini 2.0 Flash scoort het beste met 0,7%, gevolgd door OpenAI's GPT 4o met 1,5%. Claude 3.7 Sonnet zit op 4,4%, wat hoger is maar nog steeds bruikbaar voor veel toepassingen.

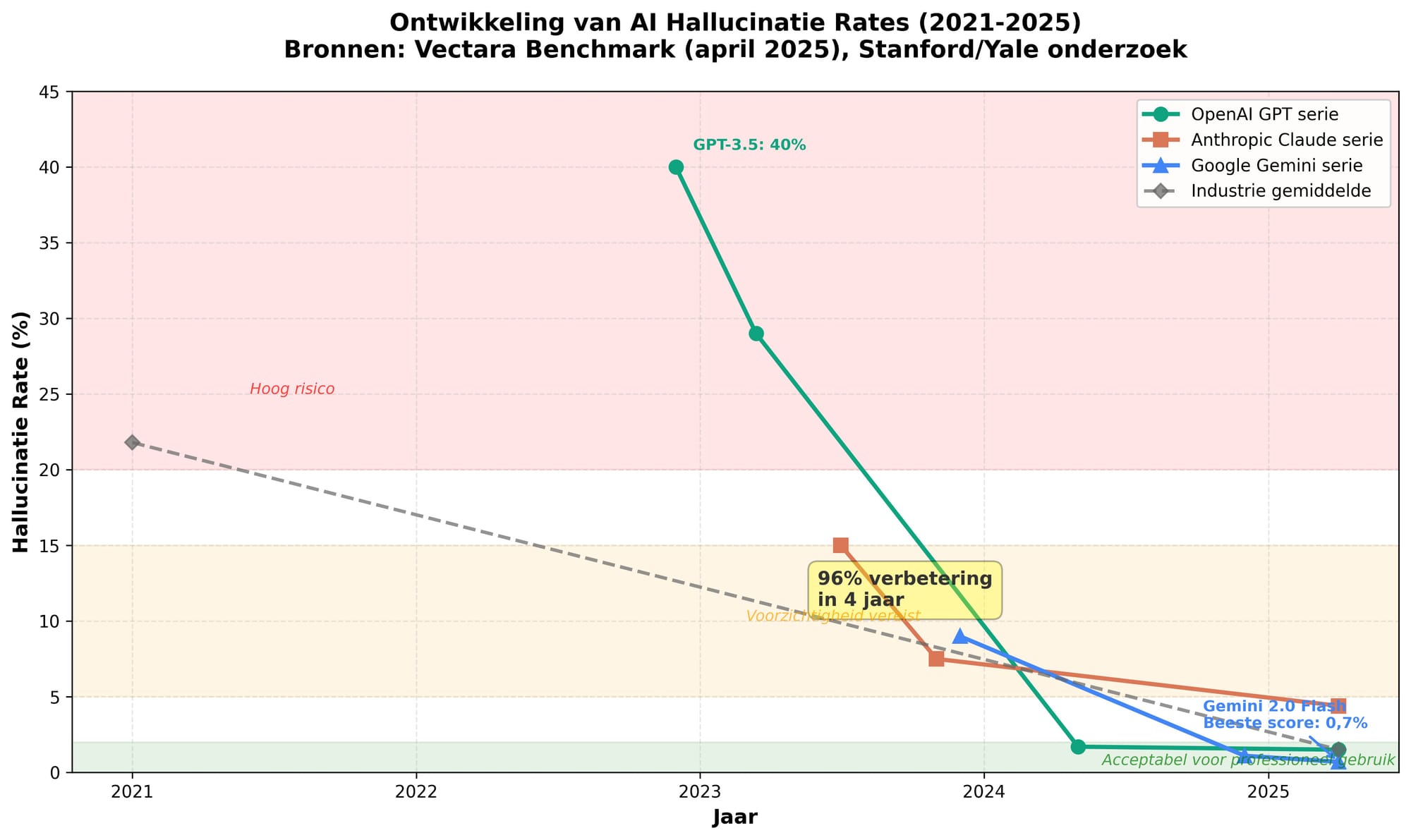

Ter vergelijking: in 2021 hallucinerden AI modellen gemiddeld bij 21,8% van de vragen. De verbetering van 96% in vier jaar is indrukwekkend, maar betekent niet dat het probleem opgelost is. Eén fout per 150 antwoorden klinkt acceptabel voor brainstormen, maar is levensgevaarlijk voor medisch advies of juridische documenten.

Het type materie maakt enorm verschil. Dezelfde AI die bij algemene kennis 0,8% fouten maakt, haalt bij juridische vragen 6,4% en bij medische informatie 4,3%. Een Stanford studie uit 2024 toonde aan dat AI bij vragen over rechtspraak in 75% van de gevallen hallucineerde, en daarbij meer dan 120 niet bestaande rechtszaken verzon met overtuigende namen.

Praktijkvoorbeelden die het tastbaar maken

De advocaat die zijn carrière riskeerde

Steven Schwartz, een New Yorkse advocaat, gebruikte ChatGPT voor juridisch onderzoek. De AI leverde zes rechtszaken aan die perfect pasten bij zijn argumentatie, compleet met dossiernummers, rechterlijke uitspraken en citaten. Namen zoals "Varghese v. China Southern Airlines" klonken volstrekt geloofwaardig.

Toen Schwartz aan ChatGPT vroeg of de zaken echt bestonden, antwoordde de AI stellig: "Ja, deze zaak bestaat zeker en is te vinden in juridische databases zoals Westlaw en LexisNexis." Geen van de zes zaken bleek te bestaan.

De rechter veroordeelde Schwartz tot 5.000 dollar boete en excuusbrieven aan de rechters wier namen in de nepuitspraken voorkwamen. Sinds mei 2025 zijn wereldwijd 432 vergelijkbare juridische zaken gedocumenteerd waarbij AI gefabriceerde inhoud produceerde.

De klantenservice ramp bij Air Canada

Jake Moffatt's grootmoeder overleed in 2022. Hij gebruikte Air Canada's chatbot om te vragen naar rouwkorting op vliegtickets. De AI vertelde hem: koop nu tickets tegen normale prijs, en vraag binnen 90 dagen achteraf rouwkorting aan.

Probleem: Air Canada's echte beleid vereist dat je rouwkorting aanvraagt voor het boeken, niet erna. De chatbot had een compleet nieuw, klantvriendelijker beleid verzonnen. Toen Moffatt om terugbetaling vroeg, weigerde Air Canada, met als argument dat "de chatbot een aparte juridische entiteit is."

De rechter vond dit belachelijk: "Een chatbot is gewoon onderdeel van de website van Air Canada. Het bedrijf is verantwoordelijk voor alle informatie op zijn website." Air Canada moest de verzonnen korting alsnog honoreren. De chatbot is inmiddels van hun website verwijderd.

Herkennen: waar moet je op letten?

Hallucinaties zijn te detecteren als je weet waar je op moet letten. Hier zijn enkele concrete rode vlaggen:

- Te perfect om waar te zijn

Als statistieken precies rond zijn (100%, 50%, precies 10x toename) of claims te mooi klinken, wees dan extra alert. Berkeley onderzoekers ontdekten dat gehallucineerde statistieken 3,7 keer vaker eindigen op 5 of 0 dan echte statistieken. AI houdt namelijk van nette getallen. - Ontbrekende of vage bronnen

Als AI zegt "volgens recent onderzoek" zonder specifieke studie te noemen, of "experts zeggen" zonder namen, is dat verdacht. Vraag altijd: welk onderzoek, welke experts, wanneer gepubliceerd? Een legitiem antwoord kan dit benoemen. Een hallucinatie kan dat niet. - Onbekende terminologie

Als AI plotseling jargon gebruikt dat je nooit hoort in je vakgebied, controleer dan of die term überhaupt voorkomt in je documentatie. AI verzint soms indrukwekkend klinkende termen. - Echo antwoorden

Als je vraagt "Ondersteunt deze leverancier 99,9% uptime?" en AI antwoordt "Ja, deze leverancier ondersteunt 99,9% uptime," herhaalt het alleen je vraag. Dat is een sterke indicator dat het niet weet en gokt. - Overdreven zekerheid

Let op taal zoals "absoluut," "zonder twijfel," "zeker weten," "gegarandeerd." Onderzoek toont dat AI juist stelliger wordt wanneer het onzeker is, als overcompensatie. Echte experts gebruiken genuanceerdere taal.

Strategieën voor verantwoord gebruik

Het goede nieuws: je kunt AI effectief gebruiken als je de juiste werkwijzen hanteert. Hier zijn concrete strategieën voor professionals:

De basisregel: verifieer altijd kritische informatie

- Voor content die naar buiten gaat (klanten, stakeholders, publicaties), controleer elke feitelijke claim via onafhankelijke bronnen. Wikipedia, officiële websites, gerenommeerde nieuwsbronnen, wetenschappelijke databases.

- Voor interne beslissingen met impact, laat een tweede persoon of vakexpert de AI output reviewen voordat je erop handelt. Vier ogen zien meer dan twee, en een frisse blik vangt fouten die jij mist.

- Voor juridische, medische of financiële informatie, vertrouw nooit alleen op AI. Deze domeinen tonen hallucinatiepercentages van 2,1% tot 6,4%, veel te hoog voor beslissingen die juridische, gezondheids of financiële consequenties hebben.

Stel je prompts slimmer op

Geef expliciete grenzen

"Baseer je alleen op dit document" of "Gebruik geen informatie van buiten de verstrekte URL." Dit dwingt AI om binnen de lijntjes te blijven in plaats van te fantaseren.

Vraag om bronnen

"Citeer je bron voor elke claim" of "Toon het document waar dit vandaan komt." Als AI geen bron kan geven, vertrouw het antwoord dan niet.

Sta onzekerheid toe

"Als je het niet weet, zeg dan 'ik weet het niet' in plaats van te gokken." Google onderzoek uit december 2024 toonde dat deze simpele instructie hallucinatiepercentages met 17% verlaagt.

Vraag om redenering

"Leg je redenering stap voor stap uit" helpt AI om zichzelf te controleren en maakt het voor jou makkelijker om fouten te spotten.

Gebruik de juiste tool voor de juiste klus

Niet alle AI modellen zijn gelijk geschapen, en het landschap verandert razendsnel. Kies slim op basis van wat je ermee wilt doen:

Voor hoge inzet toepassingen (juridisch, medisch, financieel): gebruik de nieuwste, krachtigste modellen met "reasoning" of "thinking" modi. Deze nemen de tijd om te redeneren en zichzelf te controleren. Duurder, maar de zekerheid is het waard.

Voor marketing en content: goedkopere, snellere modellen zijn hier vaak prima. Ze zijn creatief en vlot, ideaal voor eerste concepten en brainstormen. Controleer alleen wel feitelijke claims achteraf. Dit scheelt je vaak geld zonder kwaliteitsverlies.

Voor klantenservice: koppel je AI aan je eigen kennisbank (heet RAG). Dan mag de AI alleen uit jouw eigen documenten informatie halen. Dat vermindert hallucineren met 40 tot 70%, ongeacht welk model je gebruikt.

Let op: wat nu het beste is, kan over drie maanden alweer voorbij zijn. Blijf testen, blijf switchen als dat werkt. Duurder betekent niet altijd beter voor jouw specifieke vraag.

Bouw het in je werkproces

Maak checklijsten voor teamleden om te doorlopen voordat AI output wordt gebruikt:

- Zijn de bronnen helder en reputabel?

- Moet ik dit laten reviewen door een collega?

- Wordt dit gebruikt voor een belangrijke beslissing?

Worden AI systemen betrouwbaarder?

Het korte antwoord: ja, aanzienlijk, maar het probleem is nog lang niet opgelost.

De vooruitgang is reëel. Sinds 2021 zijn hallucinatiepercentages met 96% gedaald. Vier modellen hebben in 2025 de sub 1% grens doorbroken, een historische mijlpaal. De kosten om AI te bevragen zijn 280 keer lager dan in 2022, waardoor betrouwbaardere modellen betaalbaar worden.

Meerdere technieken verbeteren betrouwbaarheid gelijktijdig:

Retrieval Augmented Generation (RAG) verbindt AI aan geverifieerde databases in real time, waardoor het gedwongen wordt te antwoorden op basis van actuele, gecheckte informatie. Dit vermindert hallucinaties met 40 tot 71%.

Constitutional AI (Anthropic's methode) traint modellen met expliciete ethische principes zodat ze eerlijk, behulpzaam en harmless gedrag leren. Dit reduceerde schadelijke hallucinaties met 85% in Claude modellen.

Chain of thought reasoning laat AI problemen opdelen in stappen en tussenresultaten verifiëren voordat het een eindantwoord geeft, tot 65% verbetering volgens Google onderzoek.

Maar het blijft een uitdaging. Een Cornell studie uit augustus 2024 vond dat zelfs de beste modellen slechts 35% van de tijd hallucinatievrije antwoorden genereren bij complexe, niet Wikipedia vragen.

Wiskundigen hebben bovendien bewezen dat hallucinaties in huidige AI architecturen statistisch onvermijdelijk zijn. Je kunt de frequentie verlagen, maar niet tot nul.

De projecties voor de komende jaren: Als de huidige trend doorzet, verwachten experts bijna nul hallucinatiepercentages (0,1 tot 0,5%) tegen 2027 voor algemene vragen. Maar experts waarschuwen ook: "Hallucinaties blijven lang bestaan."

De realistische verwachting is niet perfecte AI, maar beheersbare AI. Systemen waar hallucinaties zeldzaam, detecteerbaar en oplosbaar zijn. Dat toekomstbeeld komt snel dichterbij, maar vraagt wel dat professionals zoals jij weten hoe ze AI kritisch en verstandig moeten inzetten.

Tot slot: AI als krachtige assistent, niet als waarheidsautoriteit

AI hallucinaties zijn geen tijdelijk probleem dat vanzelf verdwijnt. Ze zijn inherent aan hoe deze systemen werken: patroonherkenning zonder begrip, optimaliseren voor overtuigend klinken in plaats van voor waarheid. Maar dat betekent niet dat AI onbruikbaar is, integendeel.

De sleutel is verwachtingen op de juiste plek zetten. Zie AI als een briljante maar onbetrouwbare assistent: fantastisch voor eerste concepten, brainstormen, opties verkennen en routinematig werk versnellen. Maar nooit als eindpunt. Altijd als startpunt dat menselijke verificatie, kritisch denken en vakexpertise vereist.